Descubre cómo la elección entre Server-Side Rendering (SSR) y Client-Side Rendering (CSR) impacta directamente en tu posicionamiento en Google y aumenta tus conversiones.

Aprende a elegir la mejor estrategia para tu sitio web. Esta guía te revela cómo elegir la estrategia correcta para escalar tu SEO, mejorar la experiencia del usuario y multiplicar tus conversiones en 2026

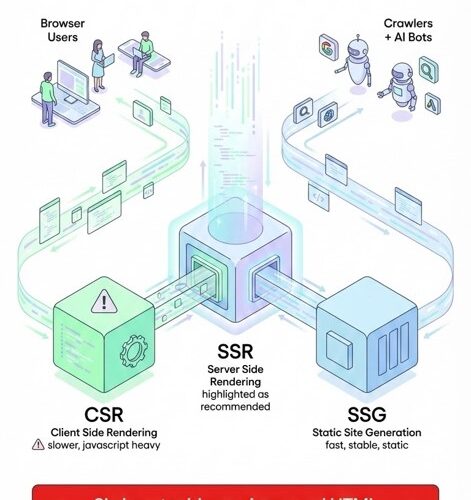

Durante años, el SEO se ha centrado en el contenido, los enlaces y los algoritmos. Pero en la era del JavaScript masivo, un nuevo campo de batalla ha surgido: el renderizado. La forma en que tu sitio genera y entrega su HTML puede determinar si es elegible o no para los crawlers de Google y las inteligencias artificiales.

La era del JavaScript masivo: cuando la web se volvió opaca

La llegada de frameworks como React, Vue o Angular transformó la arquitectura web. Lo que antes era HTML estático y legible, hoy es una capa dinámica que depende generalmente del cliente.

El problema es que, mientras los usuarios humanos ven una interfaz dinámica e interactiva, los crawlers pueden encontrarse con un vacío: un documento sin contenido, un marco genérico que solo se llena después de ejecutar JavaScript y justo aquí es donde se hace visible el SSR.

Diferencias Críticas entre Modelos de Renderizado

| Característica | Server-Side Rendering (SSR) | Client-Side Rendering (CSR) |

|---|---|---|

| Renderizado | En el Servidor (antes de enviar) | En el Navegador (cliente) |

| Visibilidad SEO | Alta (HTML listo para leer) | Riesgosa (Depende de ejecución JS) |

| Carga Inicial (FCP) | Rápida (El usuario ve contenido pronto) | Lenta (Pantalla blanca hasta cargar JS) |

| Carga de Servidor | Alta (Procesa cada petición) | Baja (Solo sirve archivos estáticos) |

| Ideal para… | Blogs, E-commerce, Noticias | Dashboards, Apps privadas (SaaS) |

¿Qué es Server-Side Rendering (SSR)?

El Server-Side Rendering (SSR) es el proceso en el que el servidor genera el HTML completo antes de enviarlo al navegador. Esto significa que el usuario (y los bots) reciben una página ya renderizada, lista para ser indexada.

Ventajas del SSR para SEO Técnico

Desde una perspectiva de SEO técnico, esto mejora la velocidad percibida, reduce los tiempos de carga inicial y facilita la indexación inmediata. Como sabemos, Google hace el análisis de los sitios en dos fases:

- Fase 1: Rastreo inmediato del HTML estático.

- Fase 2: Procesamiento diferido del JavaScript (que puede tardar horas o días).

Además, el SSR favorece los Core Web Vitals, ya que mejora métricas como el Largest Contentful Paint (LCP). Si tu página tarda en “existir”, tus ingresos también lo hacen.

¿Qué es Client-Side Rendering (CSR)?

El Client-Side Rendering (CSR) se apoya en el navegador del usuario para construir la página. Googlebot no es un navegador humano; si tu sitio requiere demasiado procesamiento, puede quedar en la cola de renderizado. Un producto mal renderizado es, para Google, un producto invisible.

Herramientas de Diagnóstico y Medición

Métricas que importan: Core Web Vitals

Google mide velocidad, estabilidad y respuesta. El renderizado del lado del servidor ayuda a optimizar métricas como el First Input Delay (FID) o el nuevo Interaction to Next Paint (INP).

Toolkit para auditar tu renderizado

No siempre lo más nuevo es lo mejor. Utiliza herramientas gratuitas para medir el impacto del JS:

- WebPageTest: Para simular conexiones lentas y dispositivos reales.

- PageSpeed Insights: Para métricas de campo y laboratorio.

Cómo inspeccionar tu sitio como un Bot

Si no sabes si tu web cumple con estas características, utiliza estas tres metodologías de chequeo rápido:

1. Google Search Console

Con su opción de inspección de URLs, te muestra cómo el Spider de Google está recibiendo el HTML renderizado y te ofrece un screenshot de lo que ve.

2. Jet Octopus (Auditoría JS)

Jet Octopus ofrece dos vistas comparativas: contenido sin JS vs. contenido con JS procesado, mostrando el porcentaje de pérdida de contenido.

3. Inspección manual en Chrome

Puedes deshabilitar el JavaScript en tu navegador para ver qué tanto depende tu contenido del renderizado del cliente (guía oficial de Google).

Reflexión final: Supervivencia Digital

La web que conocimos fue construida para ser vista. Hoy, gran parte de ella existe solo para ser interpretada. Un SSR eficiente puede salvar una marca; un CSR mal implementado puede condenarla al olvido algorítmico. En este escenario, optimizar para máquinas ya no es una opción: es una cuestión de supervivencia digital.